编者按:最近一个月爆出了三个科技热点,继ChatGPT之后OpenAI推出的文生视频模型Sora再次令世人震惊;同月,苹果推出的虚拟现实头显Vision Pro也一度成为炒作的焦点;而近日,Groq推出的定制GPU以超高的性能让人工智能的响应速度从秒级变成毫秒级。这些突破的出现让人浮想联翩:元宇宙的iPhone时刻会不会到来呢?一位知名科技博主进行了分析,文章来自编译。

[xyz-ihs snippet=”In-article-ads”]本月早些时候,Matthew Ball写了一篇很有趣的文章,文章的题目叫做《空间计算、元宇宙、遗留的术语及复活的想法》。里面跟踪了用来描述本文主题的各种术语:呃,比如虚拟现实(VR)、增强现实(AR)、混合现实(MR)、元宇宙(Metaverse)什么的,其实这些说法在科幻小说与产品当中已经流传了几十年,然后用来描述苹果所谓的空间计算。

就我个人而言,我同意Ball的看法,“元宇宙”是里面最好的一个,尤其是考虑到Ball在结论环节给这个概念做出的描述之简洁:

我喜欢“元宇宙”这个词,因为它的机制跟互联网类似,但面向的是 3D。元宇宙跟设备甚至整个计算都无关,这种无关就好比互联网与 PC 或客户端-服务器模式无关一样。 元宇宙是一个庞大且互联的,实时的 3D 体验网络。要想进入或实现光学 MR 的规模化,我们需要一个“3D 互联网”——这意味着需要对网络基础设施以及协议进行彻底改变、需要计算基础设施取得进步等等。这也许是这个词的终极挑战——它描述的更多是一种最终状态,而不是什么中间过渡。

挑战也许,或者说恰恰是这个词是合适的原因所在:元宇宙与“3D互联网”的关联程度与它跟互联网的完全可互操作及依附程度是一致的。而且,这是一条已经走滥了的道路。两年前,我在那篇《DALL-E、元宇宙与零边际内容》中写道:

长期以来,游戏一直处在技术发展的前沿,就媒体而言,情况当然是这样的。最早的电脑游戏只不过是文字罢了:

《俄勒冈之路》游戏截图 紧随其后的是图像游戏,一般是位图类型的;我记得在图书馆玩过很多次《神偷卡门》(Where in the world is Carmen San Diego)这款游戏:

《神偷卡门》游戏截图 很快,游戏就开始引入动作,你可以在 2D 世界里面给精灵指路; 紧接着3D 也出现了,在过去 25 年大部分的时间里,我们一直在致力于让 3D 游戏变得更加逼真。然而,几乎所有这些游戏都是 2D 屏幕上投射的 3D 图像。虚拟现实提供了我们置身于游戏之中的错觉。

社交媒体的发展遵循了类似的路径:先是文本,然后是图像,再到视频,而且有朝一日,会到 3D 空间里面分享体验(比方说收看 NBA 扣篮大赛);我指出生成式人工智能的也会遵循这条发展路径:

DALL-E 的迷人之处在于它指向了一个可以将这三种趋势结合起来的未来。归根结底,DALL-E 最终是人类生成内容的产物,就像它的表亲 GPT-3一样。当然了,后者是做文本生成,而 DALL-E 是图像生成的。但请注意,这是从文本迈进到了图像;接下来就会有机器学习生成的视频。当然,这可能需要几年的时间;视频这个问题会更加困难,而响应式的 3D 环境则是难上加难,但这就是这个行业以前走过的道路:

为了证明人工智能发展速度究竟有多快,“若干年”已经是悲观得令人难以置信:在那篇文章发布的几个月之后,Stable Diffusion就被用到视频生成上了,现在, OpenAI 又推出了 Sora。来自 OpenAI 网站:

Sora能够生成具有多个角色、特定类型的运动以及主体和背景的、细节准确的复杂场景,该模型不仅了解用户在提示中提出的要求,还了解这些东西在物理世界中的“存在方式”。该模型对语言有着深入理解,从而能够准确地解释提示,并生成引人注目的角色来表达充满活力的情感。 Sora 还可以在一个生成视频里面创建多镜头,且能准确地维系角色与视觉风格的一致。

当前的模型仍存在缺陷。比如它可能难以准确模拟复杂场景的物理原理,并且可能无法理解因果关系,比如,一个人咬了一口饼干,但之后视频里的饼干却没有咬痕。它还可能会混淆空间细节,比如会左右分不清楚,并且可能难以精确描述随着时间推移发生的事件,比如遵循特定的相机轨迹……

对于能够理解和模拟现实世界的模型来说,Sora 是基础,我们相信这个功能会成为实现通用人工智能(AGI)的重要里程碑。

摘录文字的最后两段让人紧张,而且也一直是 X 上面争论激烈的主题:只通过预测像素就能构建出物理现实,未来Sora会涌现出这样的模型吗?或者说Sora会是这样一个未来的迹象吗?

[xyz-ihs snippet=”GoogleADresponsive”]Sora与虚拟现实

Sora的岩石视频当中有一个更加令人难忘,提示词是“两艘海盗船在一杯咖啡中航行时互搏的逼真特写视频”( Photorealistic closeup video of two pirate ships battling each other as they sail inside a cup of coffee.)。

说实话,效果相当令人震惊,尤其是其对水和光的复现:一直到了过去这几年,电子游戏才通过光线追踪技术实现了类似的效果,即便如此,我认为Sora在效果上已经击败了那些游戏了。不过,如果你再看第二遍或者第三遍就会发现视频存在明显缺陷;只需盯住右边那艘船上飘扬的红旗,注意观察船是怎么调转方向即可:

OpenAI 的视频演示

Sora 是一个构建在 Transformer 基础之上的模型,这意味着它可以通过计算来实现质量的扩展;来自 OpenAI 关于 Sora 的技术报告:

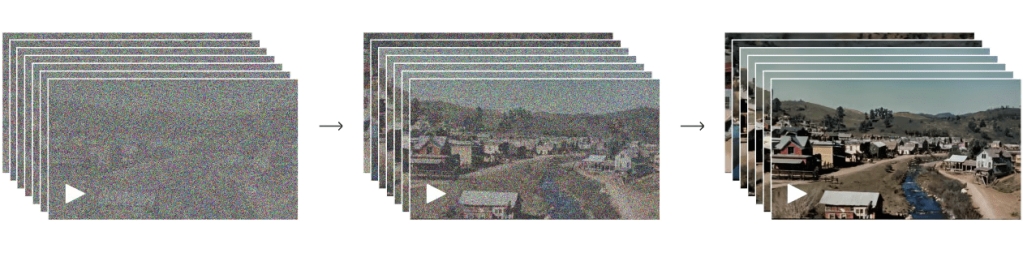

Sora是一种diffusion模型。输入特定噪音图块(patch,以及类似文本提示这样的条件信息)之后,它被训练用来预测原始的“干净”图块。很重要的一点,Sora是一种diffusion transformer。transformer在包括语言建模,计算机视觉,以及图像生成等多个领域上均展现出显著的扩展特性。

Sora 的diffuser transformer模型 在这项工作中,我们发现diffusion transformer作为视频模型同样能有效地实现扩展。下面,我们对比了带固定种子的样例视频以及训练过程中以前者作为输入生成的视频。随着训练计算量的增加,样本质量有了显著提高。

展示训练计算是如何改进 Sora 的

这说明咖啡杯里面那艘船上的旗帜可能就是固定的;但是,我怀疑最终的像素预测最终能否用来替代我上周跟 Rescale 首席执行官 Joris Poort讨论的那种高性能计算的物理建模呢?我对此表示怀疑。不妨注意一下关于飞机机翼建模的那段讨论:

我们就举个简单的例子吧,比如说流体流动。其实飞机机翼是可以分成许多个小盒子的,或者说任何类型的空气或液体都是可以放入任何一个小盒子的,然后你就可以单独去了解该小盒子(我们通常将其称为网格mesh)内的科学和物理原理,这样就很好理解了。但是,如果你观察某些更复杂的概念,比如湍流,坐飞机的时候我们都经历过湍流,湍流不是那种流畅的流动,它是不连续的,所以实际上你必须用时间切分来处理。你得观察每一个小的时间步长,对所有这些物理原理进行重新计算,好让每个单独的单元格、网格都可以进行并行计算。

这些物理模拟的目的是尽可能地接近现实;如果我对于基于 Transformer 的架构能否进行这种模拟表示怀疑的话,那么我对其“理解和模拟现实世界”的能力也应该表示怀疑;不过,这就是我要回到Ball那篇文章的原因:我们正在开发一种配得上“虚拟现实”这个词的产品。

Groq

《DALL-E、元宇宙与零边际内容》那篇文章的要点在于,生成式人工智能是让元宇宙成为现实的关键因素:

从长远来看,这指向的是这样一个元宇宙愿景,它的确定性要比典型的视频游戏低得多,但在生成内容的丰富性方面又比社交媒体丰富得多。想象一下,一个不是由艺术家绘制,而是由人工智能创造出来的环境:这不仅增加了可能性,而且至关重要的是,降低了成本。

我们并不清楚 Sora 的成本如何,但成本高昂几乎是可以肯定的;随着时间的推移,成本会逐步下降,计算领域一直以来都是这种情况。同样必要的是渲染速度要快得多:速度是当今与大型语言模型交互的挑战之一:是,准确性可能会随着计算和模型规模的扩充而增加,但这只会增加获得一个回答时遭遇的延迟量(比方说,可以对比一下用 GPT-3.5 Turbo 和用 GPT-4 进行推理的速度)。这里的答案也可能只是受摩尔定律支配,或者也许要用一种不同的架构。

[xyz-ihs snippet=”googleAD300x100″]于是就有了Groq。

Groq是由 Jonathan Ross 在 2016 年创立的。Jonathan Ross做出了谷歌的第一块张量处理单元(TPU);Ross的观点是,芯片应该向软件定义网络汲取灵感:软件定义网络用带有软件层的商用硬件来处理路由的复杂性,而不是用专门处理路由数据的专用硬件。事实上, Groq解释自家技术的那篇论文的标题叫做“用于大规模机器学习的软件定义张量流式多处理器”(A Software-defined Tensor Streaming Multiprocessor for Large-scale Machine Learning)。

为此, Groq先从编译器做起,编译器软件会将代码翻译成芯片可以理解的机器语言;其目标是能够将机器学习算法简化成一种可以在极其简单的处理器上执行的格式,这些处理器可以用非常高的速度运行,但又不会出现代价高昂的内存调用和预测错误(这正是现代处理器相对较慢的原因)。

最后的结果是Groq 的芯片具备了纯粹的确定性:Groq用的不是现代 GPU 使用的那种高带宽内存 (HBM) 或计算机所使用的动态随机存取内存 (DRAM),那两种芯片都需要定期刷新才能运行(这会引入延迟,特定时刻数据位置会有不确定性),而是用 SRAM — 静态随机存取存储器。 SRAM 把数据存储在所谓的双稳态锁存电路中;跟支撑 DRAM(以及更大范围的 HBM)的晶体管/电容器架构不同,SRAM会以稳定状态来存储数据,这意味着Groq始终能准确地知道每个数据在任何特定时刻放在哪里。这样一来,在理想情况下Groq编译器就能够预先定义每一次内存调用,从而用相对简单的架构实现极快速的计算。

事实证明,在基于 Transformer 的模型上进行推理是一种极其理想的情况,因为计算本身具有极高的确定性。像 GPT-4 这样的大语言模型(LLM)通过一系列具有预定操作集的神经网络层来处理文本,这非常适合Groq 的编译器进行处理。同时,基于标记(token)的生成属于纯粹的串行操作:生成的每个标记都依赖于对前一个令牌的了解;任何特定答案的并行度都是零,这意味着用来进行标记计算的速度绝对是物超所值的。

而且结果也很显著:

用定制GPU进行大模型推理,响应速度变成毫秒级而不是秒级

这种加速实在是太显著了,以至于与大语言模型的互动体验都发生了巨大变化;这还可以让你有可能与大语言模型进行实时的交流,甚至可以跨越半个地球,在电视上做直播:

关于为什么 OpenAI 首席执行官山姆·阿尔特曼(Sam Altman)要做硬件的可能性,我提出的其中一个观点是,人工智能越接近人类,与所述人工智能进行交互遭遇的那些小小不便就会愈发令人烦恼并最终受到限制。你得坐在办公桌前用电脑才能交互会变成麻烦,甚至伸进兜里掏出智能手机都会变成麻烦:这样给你的感觉是始终都在跟设备进行明确的交互。在类似人类的人工智能环境下必须打开app或等待文本输出要痛苦得多:这会以一种更深刻、最终令人失望的方式打破幻想。但现在 Groq描绘了一条让我们维持幻想的路径。

搭建在Groq之上的Sora

令人惊讶的是, Groq是一个执行确定性软件的确定性系统,但最终产生的却是概率性的输出。我在《ChatGPT有了一台计算机》里面解释了确定性计算与概率性计算的差异:

计算机是确定性的:如果电路 X 是开路的话,则 X 所代表的命题为真; 1加1永远等于2;单击浏览器上的“后退”将退出此页面。当然,从单个晶体管到我们可能对计算机采取的任何操作,这中间存在大量抽象和大量逻辑——实际上可能会出现 bug 的地方其数量近乎无限——但计算机有一个得当的心智模式,那就是它们完全会按照编程指令执行操作(事实上,计算机出现的错误不是计算机犯了错,而是程序员告诉计算机做了错误的事情)。

我已经提到了 Bing Chat 与 ChatGPT; 3 月 14 日,Anthropic 发布了另一个叫做 Claude 的 AI 助手:虽然公告当中没有明确说明,但我想这个名字是为了纪念前面提到的香农(Claude Shannon)。

这当然是一种高尚的情感表达——香农对信息论的贡献远远超出了 Dixon 上面所列的范围——但却让人感觉是表错了情:虽然从技术上来讲,人工智能助手所做的一切最终都是由 1 和 0 组成的,但它们的操作方式却是从训练中涌现出来的,而非源自固定规则,这导致它的体验感觉与逻辑计算机有着根本的不同,那种体验感觉更接近人类,这又把我们带回到幻觉上; Sydney 是很有趣,但如果它面对的是家庭作业呢?

《ChatGPT有了一台计算机》背后的想法是,大语言模型的运作方式似乎与人脑有点相似,人脑之神奇令人难以置信,但人脑也不够精确,就像我们需要计算机来进行精确计算一样,ChatGPT 也是如此。不过,普通计算机其实跟Groq正好相反:由于现代处理器和内存的设计使然,其实普通计算机的概率学比你想象的要高的,但它执行的软件假设处理器会处理没完没了的内存调用以及分支预测,最终反而能给你一个确定性的结果。

但最终,我们又回到了原先开始的地方:计算机会知道船头和船尾在船的什么位置,而像 Sora 这样基于transformer的模型则做出了错误的猜测。前者计算的是物理现实;后者计算的是虚拟现实。

不过,想象一下,如果让Sora 在Groq上面跑的话(这绝对是可行的):我们可以实时生成视频吗?即便不能实时生成视频,我们也肯定比你想象的要接近得多。你可能会问,那去什么地方观看这些视频呢?在 Apple Vision Pro 或 Meta Quest 等头戴式显示器上面观察如何?用虚拟现实(我的新定义)服务虚拟现实(旧定义)。

即将到来的虚拟现实时刻

iPhone 的诞生并不是凭空而来的。 苹果需要学习如何制造 iPod 等低功耗设备;闪存需要价格跌到用户可承受才变得可行;三星需要制造出足够好的处理器; 3G网络需要推出; iTunes 音乐商店需要为应用商店奠定基础; Unity 需要担负起一个错误的使命,也就是为 Mac 开发游戏引擎。不过,这一切在 2007 年都实现了,于是移动时代爆发了。

三年前, Facebook 更名为 Meta,标志着元宇宙时代的开始,但他们很快就变成了大家的笑料;这家公司似乎太快地推进了太多的技术。不过,苹果也许遇到了更好的时机:值得注意的是,Vision Pro 与 Sora 都是在同一个月推出的,就像Groq开始表明实时推理比我们想象的也许更容易实现。与此同时,台积电正在向 2纳米 制程迈进,而英特尔也正在尝试加入他们的行列,而由于大语言模型的普遍存在,对高性能芯片的需求正在猛增。

郑重声明一句,在虚拟现实方面我不认为我们正迈入 iPhone 时代,我的意思是一款完美产品正面临多种技术创新交叉出现的时刻。不过,令人兴奋的是,与三年前不同,这块拼图的很多碎片已在眼前。 Sora可能还不够好,但会变得更好; Groq可能不够便宜或不够快,但它以及任何出现的其他竞争对手都将在这两个方面取得进展。按照我的估计,Meta 和苹果本身还没有完全把硬件搞定。不过,从各个方面来看,你已经能看到一条从起点走到目的地的道路。

当然,最重要的区别是手机在 iPhone 之前就已存在:卖更好的手机很容易。一个我们现在才能够回答的大问题是:对于相当多的人来说,虚拟现实会不会变成更好的现实呢?

来源:36氪。译者:boxi。

[xyz-ihs snippet=”MoreTechNews”] [xyz-ihs snippet=”multiple-ads”]

785 views